작성일: 2024년 8월 7일

Ubuntu 22.04, Ubuntu 24.04에서 부팅 시간이 긴 현상

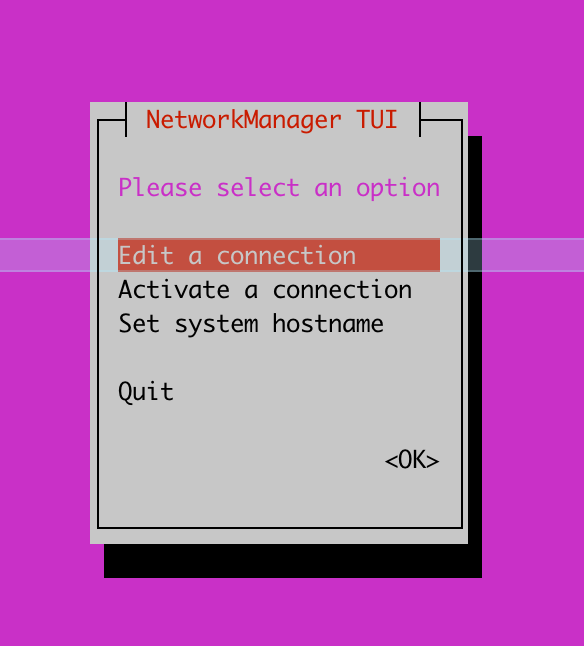

Ubuntu를 설치하고, 부팅할 때 아래와 같이 Network 설정 화면에서 오랜 시간 대기하는 경우가 있다.

A start job is running for wait for network to be configured

일단, Ubuntu OS가 부팅되면 root 계정으로 아래와 같이 설정을 수정하고 reboot하면, 빠르게 부팅될 것이다.

##

## Network connection을 기다라지 않기 위해 아래와 같이

## systemd-networkd-wait-online.service 서비스를 비활성화한다.

##

$ systemctl disable systemd-networkd-wait-online.service

##

## 다른 서비스에 의해서 systemd-networkd-wait-online.service 서비스가 활성화되는 것을 막기 위해

## 아래와 같이 systemd-networkd-wait-online.service 서비스를 masking한다.

##

$ systemctl mask systemd-networkd-wait-online.service

참고:

DHCP 설정 Off는 위 이슈와 관련은 없지만, 0.1초라도 부팅 시간을 줄이고자 한다면 DHCP를 off하는 것이 좋다.

(물론, DHCP를 사용할 일이 없을 때만~~~)

##

## DHCP로 IP address 설정할 필요가 없다면, DHCP 기능을 끈다.

##

$ cat /etc/netplan/00-installer-config.yaml

... 중간 생략 ...

enp7s0:

dhcp4: false

... 중간 생략 ...

$

##

## 채용 관련 글

##

제가 일하고 있는 기업 부설연구소에서 저와 같이 연구/개발할 동료를 찾고 있습니다.

(이곳은 개인 블로그라서 기업 이름은 기재하지 않겠습니다. E-mail로 문의주시면 자세한 정보를 공유하겠습니다.)

근무지 위치:

서울시 서초구 서초동, 3호선 남부터미널역 근처 (전철역 출구에서 회사 입구까지 도보로 328m)

필요한 지식 (아래 내용 중에서 70% 정도를 미리 알고 있다면 빠르게 협업할 수 있음):

- 운영체제 (학부 3~4학년 때, 컴퓨터공학 운영체제 과목에서 배운 지식 수준):

예를 들어, Processor, Process 생성(Fork)/종료, Memory, 동시성, 병렬처리, OS kernel driver

- Linux OS에서 IPC 구현이 가능

예를 들어, MSGQ, SHM, Named PIPE 등 활용하여 Process간 Comm.하는 기능 구현이 가능하면 됨.

- Algorithm(C언어, C++ 언어로 구현 가능해야 함)

예를 들어, Hashtable, B-Tree, Qsort 정도를 C 또는 C++로 구현할 수 있을 정도

- Network 패킷 처리 지식(Layer 2 ~ 4, Layer 7)

예를 들어, DHCP Server/Client의 주요 Feature를 구현할 정도의 능력이 있으면 됨.

- Netfilter, eBPF 등 (IP packet hooking, ethernet packet 처리, UDP/TCP packet 처리)

- IETF RFC 문서를 잘 읽고 이해하는 능력 ^^

# 위에 열거한 내용 외에도 제가 여기 블로그에 적은 내용들이 대부분 업무하면서 관련이 있는 주제를 기록한 것이라서

# 이 블로그에 있는 내용들을 잘 알고 있다면, 저희 연구소에 와서 연구/개발 업무를 수행함에 있어서 어려움이 없을 겁니다.

회사에서 사용하는 프로그래밍 언어:

- 프로그래밍 언어: C, C++, Go

(참고: 아직 연구소 동료들이 Rust를 사용하진 않습니다만, 새 언어로써 Rust를 사용하는 것을 고려하는 중)

근무 시간:

- 출근: 8~10시 사이에서 자유롭게 선택

- 퇴근: 8시간 근무 후 퇴근 (오후 5시 ~ 7시 사이)

- 야근 여부: 거의 없음 (내 경우, 올해 상반기 6개월간 7시 이후에 퇴근한 경우가 2회 있었음)

- 회식 여부: 자유 (1년에 2회 정도 회식하는데, 본인이 집에 가고 싶으면 회식에 안 감. 왜 참석 안 하는지 묻지도 않음)

외근 여부:

- 신규 프로젝트 멤버 -> 외근 전혀 하지 않음 (나는 신규 프로젝트만 참여해서 지난 1년 동안 한번도 외근 없었음)

- 상용 프로젝트 멤버 -> 1년에 5회 미만 정도로 외근

팀 워크샵 여부:

- 팀 워크샵 자체를 진행하지 않음. (워크샵 참석하는 거 싫어하는 개발자 환영 ^^)

연락처:

- "sejong.jeonjo@gmail.com" # 궁금한 점은 이 연락처로 문의주세요.

- 블로그 비밀 댓글 (제가 하루에 한번씩 댓글 확인하고 있음)

원하는 인재상:

- 우리 부설연구소는 "긴 호흡으로 프로젝트를 진행"하기 때문에 최소 2년간 한 가지 주제를 꾸준하게 연구/개발할 수 있는 개발자를 원함.

- 우리 부설연구소는 자주적으로 연구 주제를 찾아서 업무를 하기 때문에 능동적으로 생각하고 행동하는 동료를 원함.

- 차분하게 연구 주제에 몰입하고, 해법을 찾는 것을 즐기는 사람.

내가 느끼는 우리 연구소의 장점:

- 갑/을 관계가 없음. (제가 근무하고 있는 연구소는 SI업종이 아니라서 갑/을 회사 개념이 없음)

- 연구소 자체적으로 연구 주제를 발굴하고 시스템을 개발하기 때문에 개발 일정에 대한 스트레스가 적음

- 빌딩 전체를 우리 회사가 사용하므로 분위기가 산만하지 않음.

- 근처에 예술의전당, 우면산 둘레길이 있어서 점심 시간에 산책하기 좋음 ^^

- 연구소 동료들 매너가 Good (2년간 일하면서 한번도 감정에 스크레치 생기거나 얼굴 붉히며 싸운 적 없음 ^^)

'Ubuntu' 카테고리의 다른 글

| dd 명령으로 Storage I/O 성능 확인 (0) | 2023.02.20 |

|---|---|

| Ubuntu TimeZone 설정 (서울 표준시) (0) | 2023.01.06 |

| Linux CLI 명령으로 PPTP 서버와 연결하기 (GRE 터널 연결 요청) (0) | 2022.12.22 |

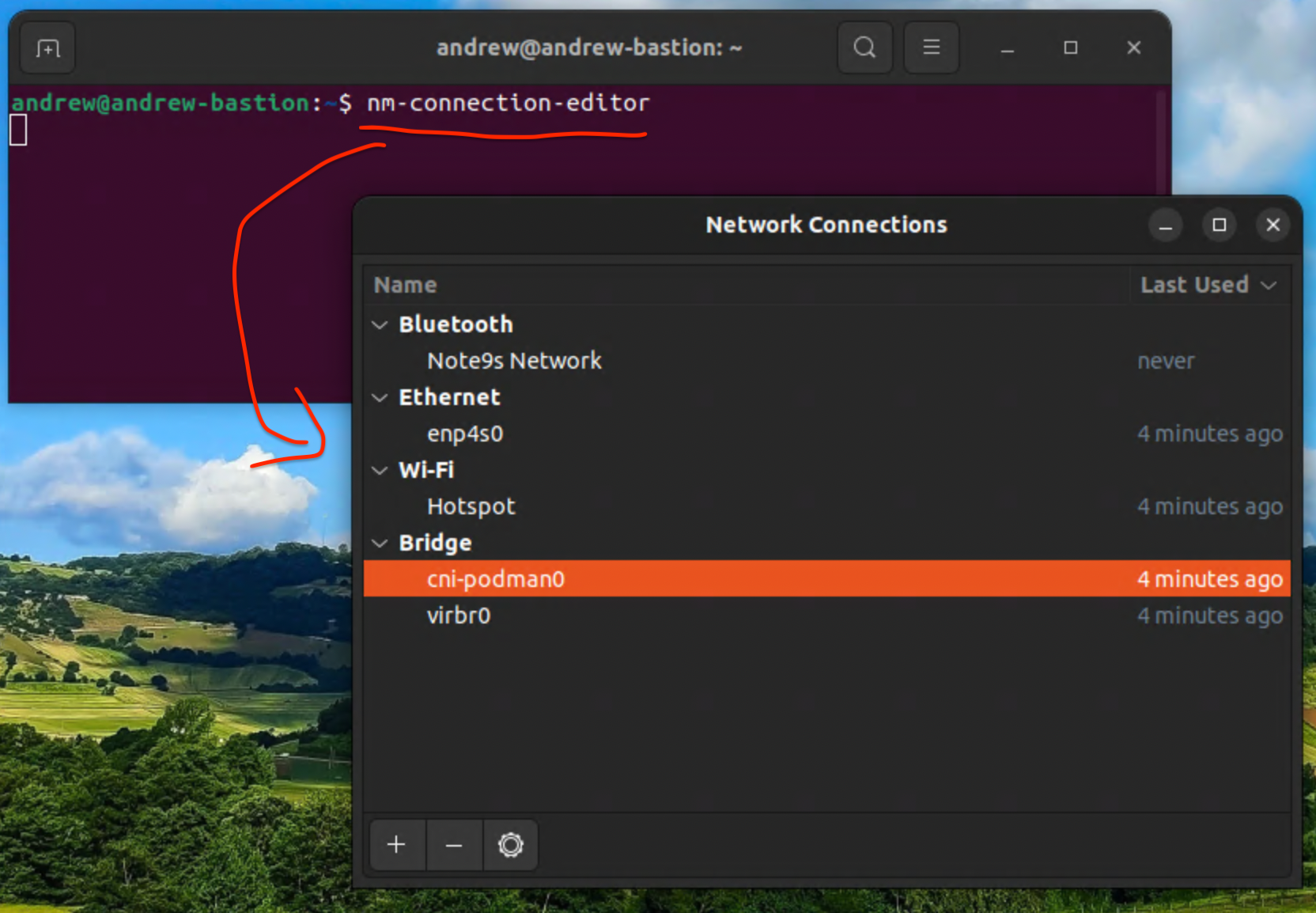

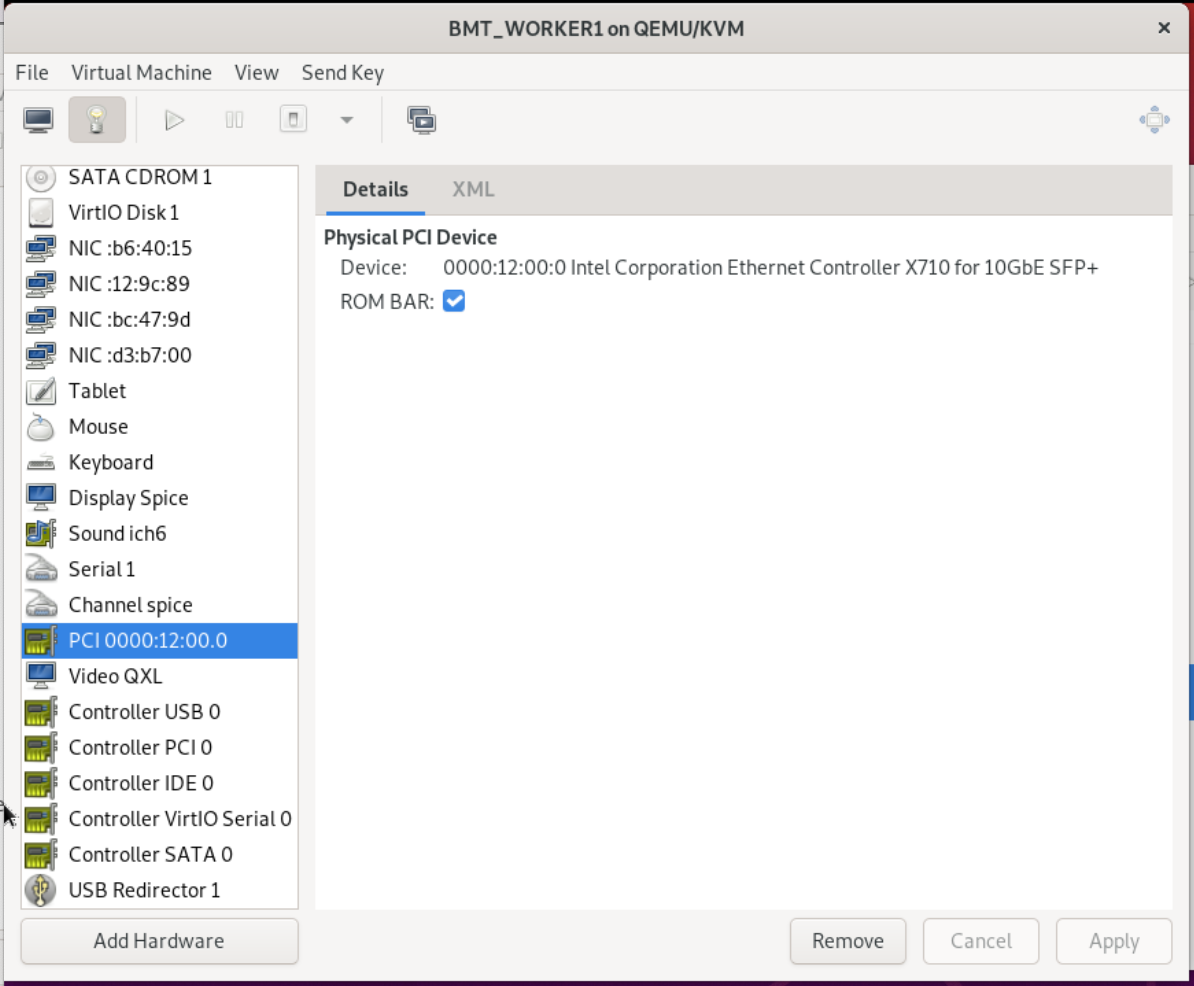

| Ubuntu Network 설정 (nmtui, netplan, nm-connection-editor 명령) (0) | 2022.11.24 |

| Linux, Windows CPU Memory 사용량 계산 (Go Lang) (0) | 2022.07.29 |