작성일: 2025년 11월 10일

KVM을 사용하다보면, Virt-Manager라는 GUI 툴이 조작하기 편해서 계속 Virt-Manager만 사용하게 된다.

그런데 가끔 SSH 터미널만 사용할 수 있는 환경이거나 CLI Command만 이용해서 Script를 작성할 때는 virsh를 꼭 사용해야 한다.

Virtual Machine 생성하기 (그리고 VM에 OS 설치하기)

##

## 2023년 1월에 실제 Ubuntu 설치할 때 사용했던 명령.

## 참고: --disk 옵션에 기존에 사용했던 qcow image file을 사용하면 kernel을 못 찾는다는 에러 발생.

## 원인은 아직 모르겠음.

## 참고: 아래 명령을 수행하고 대략 55초 정도 지나야 Console에 text message가 출력된다.

## (내가 사용한 HW Spec: i7-11700, 64GB)

## 따라서 느긋하게 기다려야 제대로 설치가 가능하다.

##

## 참고: size 단위는 GB.

## Case: OS 설치하면서 VM instance 시작하기

## (주의: OS 설치하면서 VM start 할 때는 --osinfo 옵션을 빼야 한다.)

$ virt-install \

--name my-vm \

--ram 4096 \

--vcpus 2 \

--disk /mnt/sda1/virtual_storage/waas.qcow2,size=100 \

--disk /mnt/hdd0/virtual_machine/harbor-2nd-storage.qcow2,size=500 \

--graphics none \

--network network=br-ex \

--console pty,target.type=virtio \

--autoconsole text \

--location /home/iso/ubuntu-22.04.1-live-server-amd64.iso

## Case: 기존 사용했던 VM 이미지를 이용하여 VM instance 기동하기.

$ virt-install \

--import \ ## 기존 VM image 파일을 이용하겠다는 옵션

--osinfo ubuntu22.04 \ ## 이 osinfo 옵션을 꼭 추가해야 한다.

--name my-vm \

--ram 4096 \

--vcpus 2 \

--disk /mnt/sda1/virtual_storage/waas.qcow2,size=100 \

--graphics none \

--network network=br-ex \

--console pty,target.type=virtio \

--autoconsole text

##

## CPU Pinning, Hugepages 설정이 필요해서 사용했던 명령.

##

$ virt-install --import \

--name my-machine \

--vcpus 4 \

## CPU Pinning

--cpuset=2,4,6,8,10,12,14,16,18,20,22,24,26,28,30,32 \

--memory=4096 \

## Hugepages

--memorybacking hugepages=on \

--numatune 0 \

--disk /mydir/my-machine.qcow2 \

--network bridge=my-br \

--network bridge=ems-br \

--os-variant rhel7.9 \

--noautoconsole

##

## 주의:

## 아래 --osinfo, --os-variant 옵션을 사용하면 VM instance 생성할 때 오류가 발생한다.

## 꼭 필요한 옵션이 아니니까, 아래 2가지 옵션을 사용하지 않는 것이 좋다. (2023년 1월 현재)

## --osinfo ubuntu22.04

## --os-variant ubuntu22.04

##

##

## 주의:

## VM instance 내부에서 OS 설치가 끝나고, 자동 reboot되어야 하는게 정상이지만

## 가끔 OS termination 단계에서 실패하고 멈춘 경우가 있다.

## reboot 시도 후 30초 후에도 console 화면의 변화가 없다면

## 과감하게 VM instance destroy를 시도한다. (아래 명령을 사용)

##

$

##

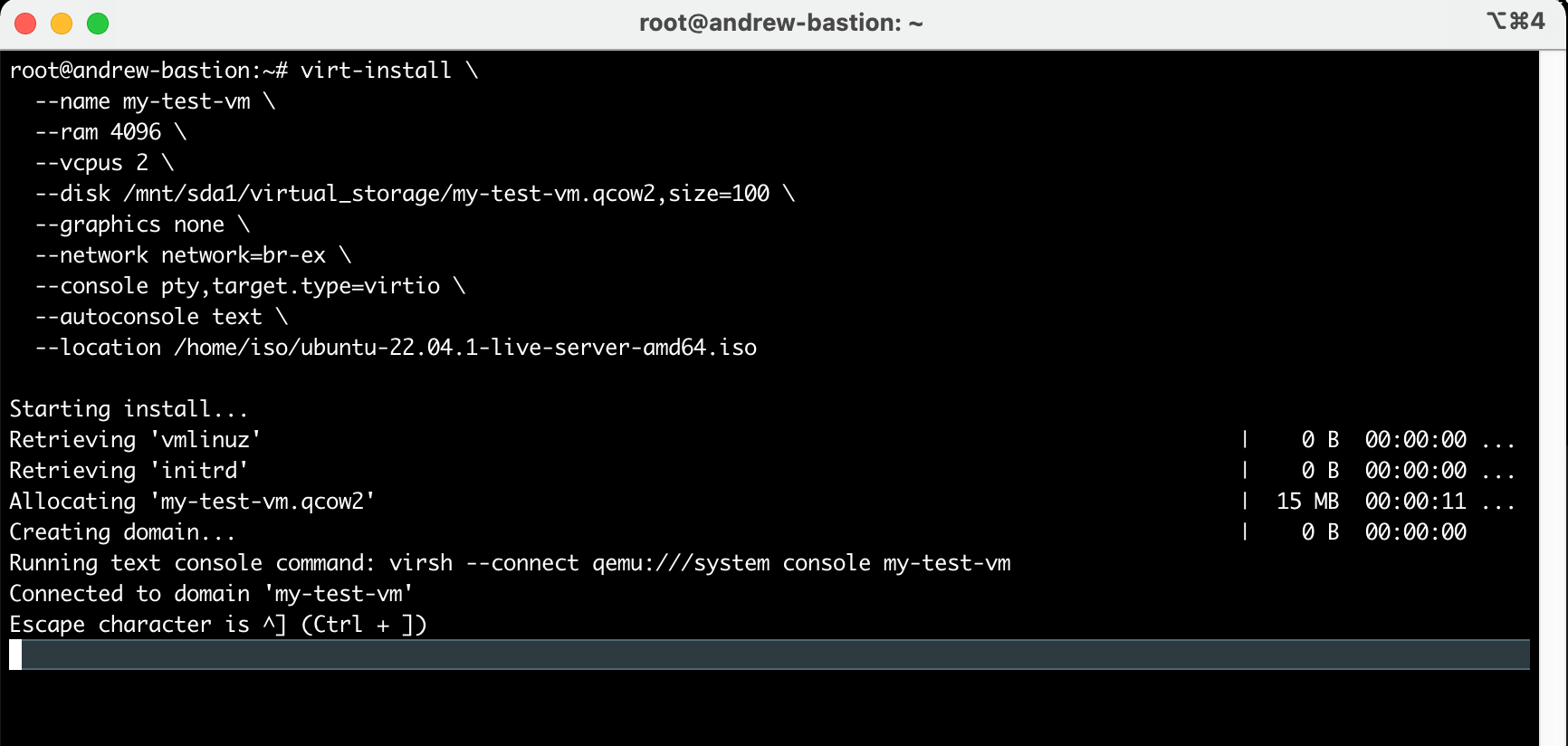

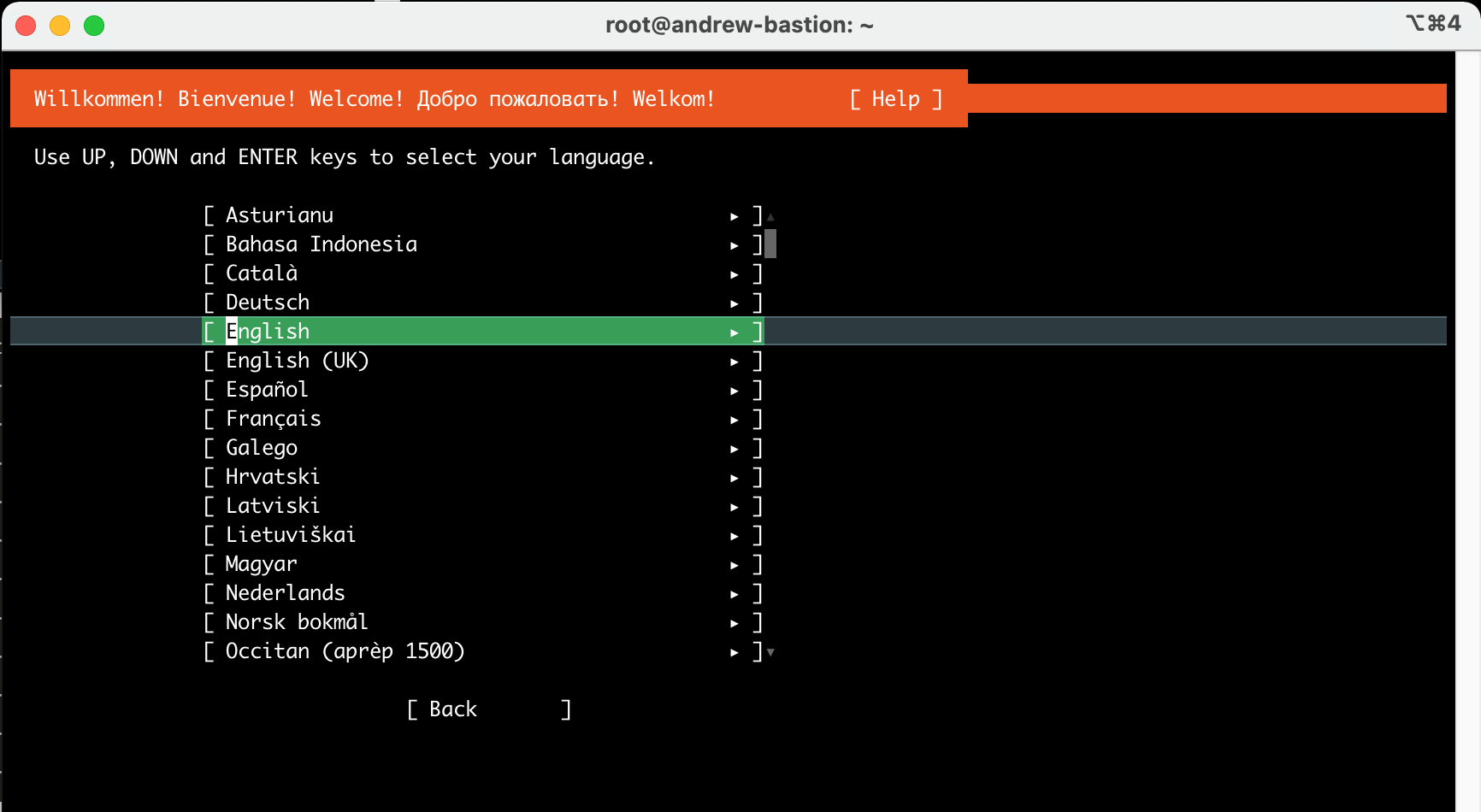

위 `virt-install` 명령을 실행하면, 바로 아래 화면이 출력되고

이 화면에서 대략 55~60초 정도 기다려야 다음 설치 화면으로 넘어간다.

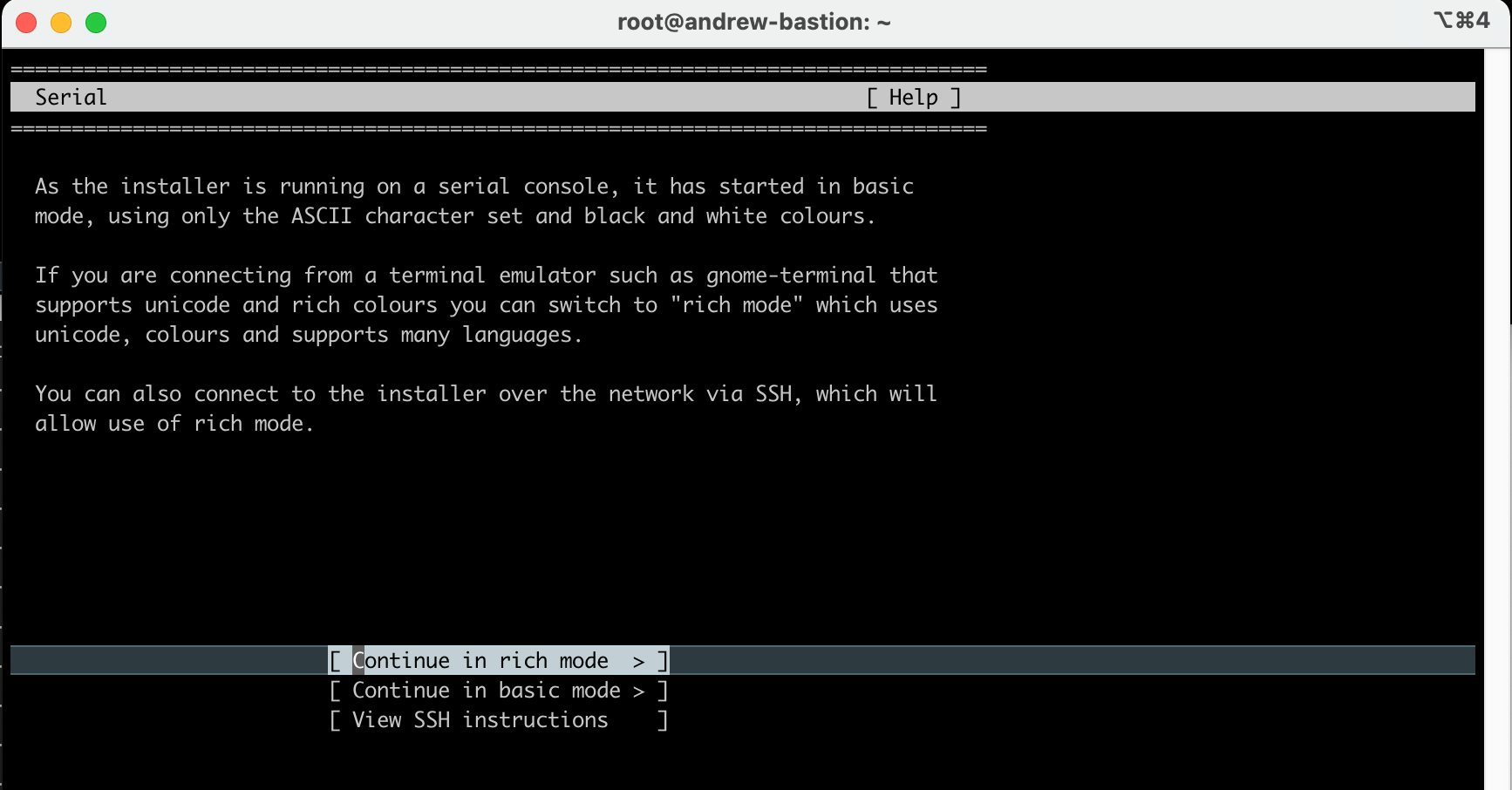

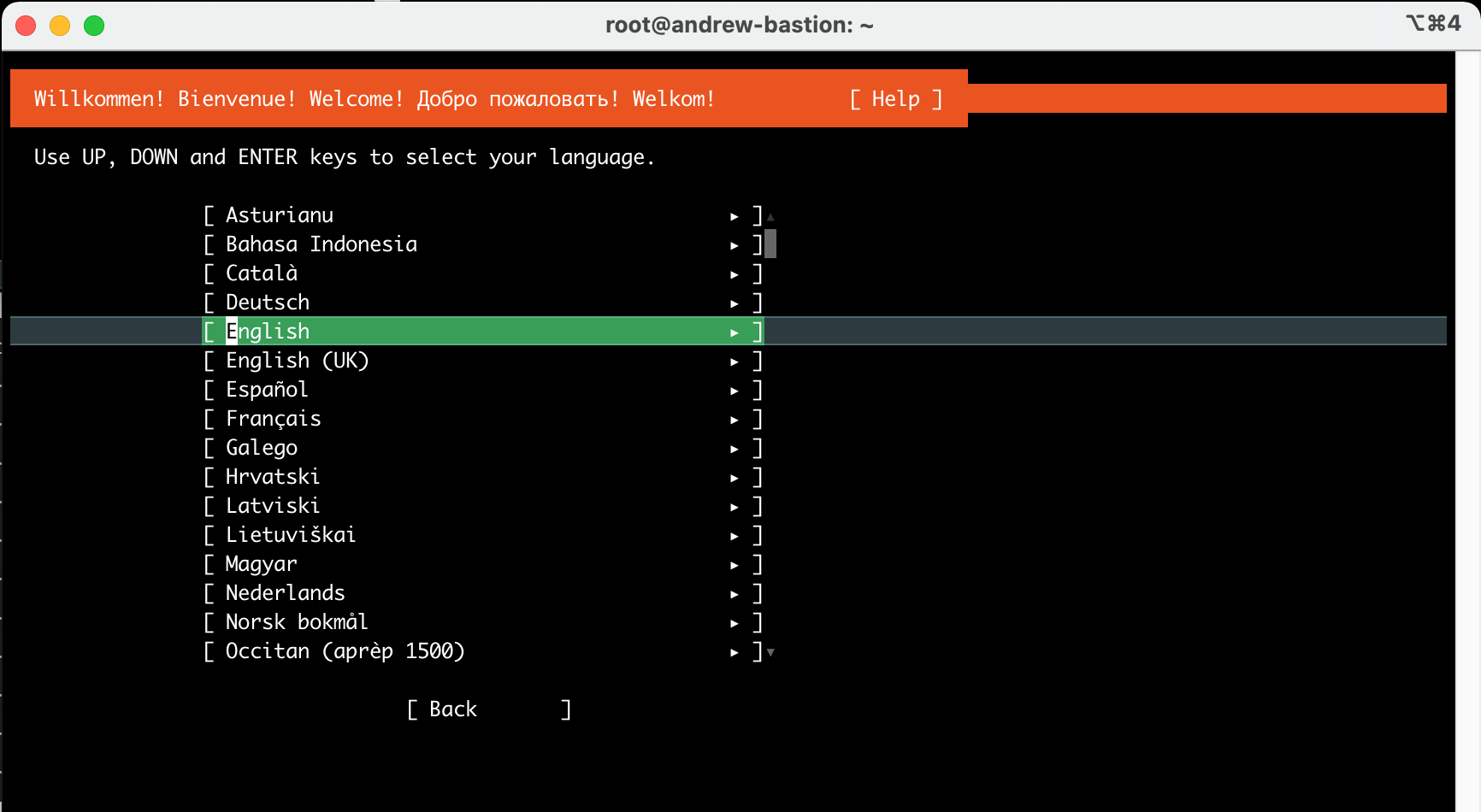

위 화면에서 대략 55~60초 정도 기다리면, 드디어 아래와 같이 OS 설치 시작 화면이 나온다.

비록 Text Terminal 이지만, 조금이라도 예쁜 설치 화면을 원하면 "rich mode"를 선택한다.

이후부터는 일반적인 Ubuntu OS 설치 절차와 같다.

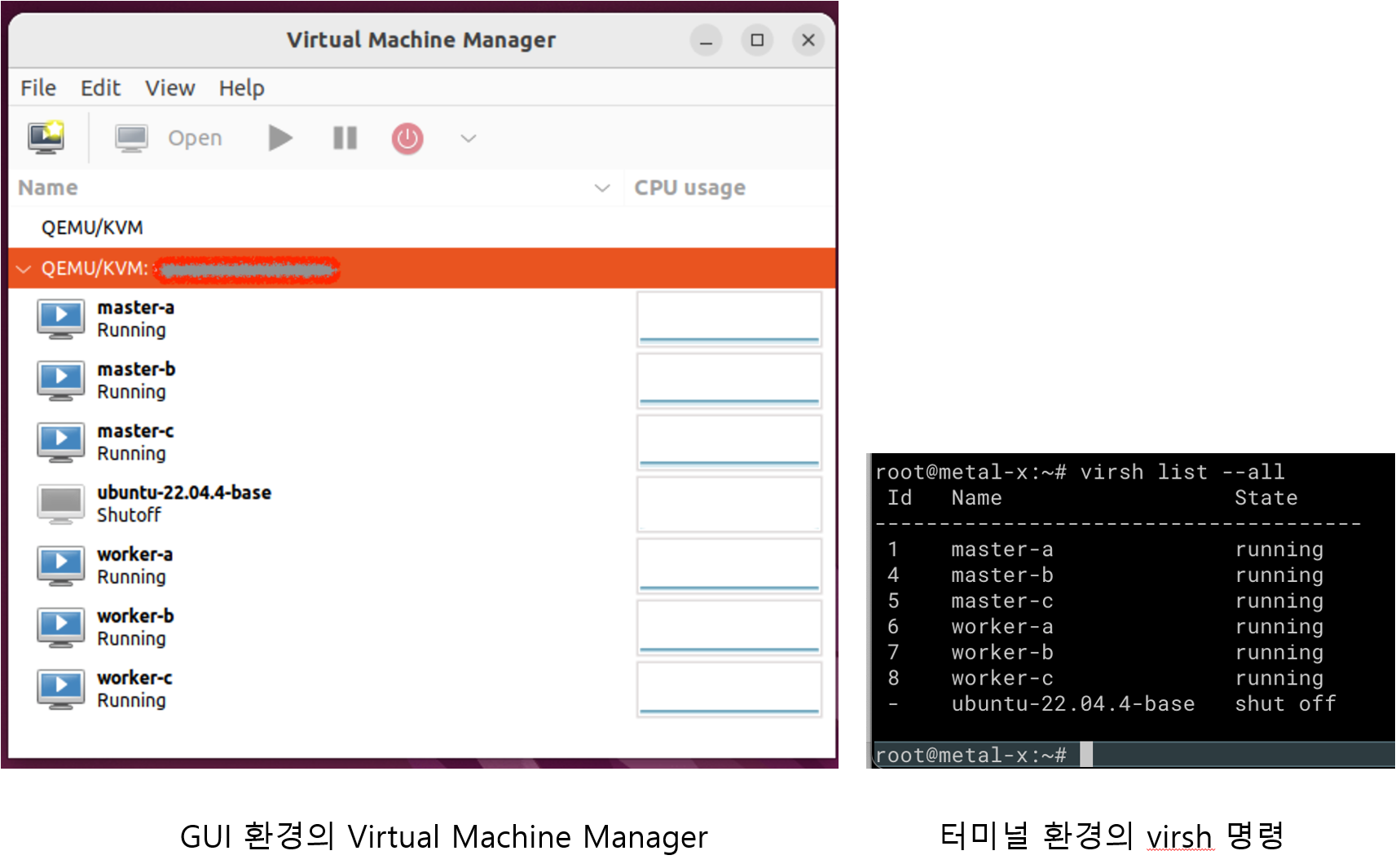

Virtual Machine 목록 보기

$ virsh list --all

Id Name State

-------------------------

1 x-node running

- am0 shut off

- aw0 shut off

- aw1 shut off

$

Virtual Machine 기동하기

##

## am0 가상 머신을 기동하기

##

$ virsh start am0

Domain am0 started

##

## am0 가상 머신이 기동되었는지 확인하기

##

$ virsh list --all

Id Name State

-------------------------

1 x-node running

2 am0 running

- aw0 shut off

- aw1 shut off

$

Virtual Machine 종료하기

##

## Graceful Termination of VM instance

## (참고로, 아래 숫자 2는 VM의 ID이다)

##

$ virsh shutdown 2

Domain 2 is being shutdown

$

##

## VM instance 강제 종료

## (참고로, 아래 숫자 2는 VM의 ID이다)

##

$ virsh destroy 2

##

## VM instance 삭제하기

##

$ virsh undefine vm-name

Virtual Machine의 Console에 접속하기

$ virsh console x-node

Connected to domain x-node

Escape character is ^]

CentOS Linux 8

x-node login: root

Password: ......

[root@x-node ~]# _

qcow2 image file size 조정 (resize)

##

## 원하는 size로 vm image를 재조정할 수 있다.

## 최초에 작게 만들어진 volume image 용량을 더 크게 늘리기 위해서 사용한다.

##

$ qemu-img resize myvm.qcow2 100G

##

## 아래 명령과 같이 수행하여 기존 VM image에서 빈 공간을 제거하고 size를 줄일 수 있다.

## 보통 qcow2 파일을 다른 장비로 옮길 때, vm image size를 줄이기 위한 용도로 사용된다.

## 참고: 원본 qcow2 이미지 파일은 유지되므로 별도로 백업하지 않아도 된다.

$ qemu-img convert -O qcow2 source_image.qcow2 shrunk_image.qcow2

##

## volume image 정보를 열람한다.

##

$ qemu-img info myvm.qcow2

qcow2 image 파일 생성하기

##

## 만약 qcow2 type의 virtual volume을 만들고 싶다면 아래와 같이 명령을 수행.

## Volume size는 250GB로 지정했지만, 실제로는 qcow2 파일에 meta data만 생성하기 때문에

## 실제 사이즈는 1MB 밖에 안 되고, 시간도 3초 정도 밖에 안 걸린다.

##

$ qemu-img create -f qcow2 my-virtual-volume.qcow2 250G

물리 Disk를 가상 Disk로 Import하기 (또는 백업하기)

##

## 아래 명령은 물리 저장 장치(HDD)를 외장 USB에 연결한 것을 가정하고 실행한 예시이다.

##

$ qemu-img convert -f raw -O qcow2 /dev/sdb /opt/vm/my_hdd.qcow2

VM의 OS Type 전체 목록 열람하기

$ virt-install --osinfo list

...

ubuntu-lts-latest, ubuntu-stable-latest, ubuntu22.04, ubuntujammy

ubuntu21.10, ubuntuimpish

ubuntu21.04, ubuntuhirsute

ubuntu20.10, ubuntugroovy

ubuntu20.04, ubuntufocal

...

$

기존 VM instance에 disk 추가하기

$ virsh edit my-vm

... 중간 생략 ...

<devices>

<emulator>/usr/bin/qemu-system-x86_64</emulator>

<disk type='file' device='disk'>

<driver name='qemu' type='qcow2' discard='unmap'/>

<source file='/var/lib/libvirt/images/my-vm-a.qcow2'/>

<target dev='vda' bus='virtio'/>

<boot order='1'/>

<address type='pci' domain='0x0000' bus='0x05' slot='0x00' function='0x0'/>

</disk>

##

## FIXME: 이 부분을 추가한다.

##

<disk type='file' device='disk'>

<driver name='qemu' type='qcow2'/>

<source file='/opt/virtual_storage/vol_01.qcow2'/>

<target dev='vdb' bus='virtio'/>

<address type='pci' domain='0x0000' bus='0x09' slot='0x00' function='0x0'/>

</disk>

... 중간 생략 ...

$ virsh reboot my-vm

## 또는 아래와 같이 hypervisor를 restart한다.

$ systemctl restart libvirt-bin

위 방식과 다르게 virt-install 명령으로 disk를 추가하여 VM instance를 재시작한다.

virt-install \

--import \

--name my-vm \

--osinfo ubuntu22.04 \

--ram 2048 \

--vcpus 2 \

--disk /opt/virtual_machine/my-vm.qcow2 \

--disk /opt/virtual_machine/my-new-disk.qcow2 \

--graphics none \

--network network=br-ex \

--console pty,target.type=virtio \

--autoconsole text

VM의 CPU에 Host의 CPU를 Pinning

## CPU pinning 설정하는 명령어

virsh vcpupin <vm-name> <vcpu-number> <host-core-number>## CPU pinning 설정하기

## - "VM CPU core id 0"은 "Host CPU core id 12"를 사용하도록 고정

## - "VM CPU core id 1"은 "Host CPU core id 13"를 사용하도록 고정

## 위 내용을 실제로 설정하려면, 아래와 같이 명령을 실행하면 된다.

$ virsh vcpupin myvm 0 12

$ virsh vcpupin myvm 1 13

## CPU pinning 상태 확인하기

$ virsh vcpupin myvm

VCPU CPU Affinity

----------------------

0 12

1 13

'Virtualization' 카테고리의 다른 글

| KVM에서 만든 Win 11 VM의 화면 해상도 설정 변경 (고해상도 설정) (0) | 2025.10.15 |

|---|---|

| Cloud Infra 실제 사용 비용 (사용자가 체감하는 실질 요금) (0) | 2024.04.09 |

| Public Cloud Infra 사용시 주의할 점 (숨겨진 비용, Hidden Cost) (0) | 2024.04.09 |

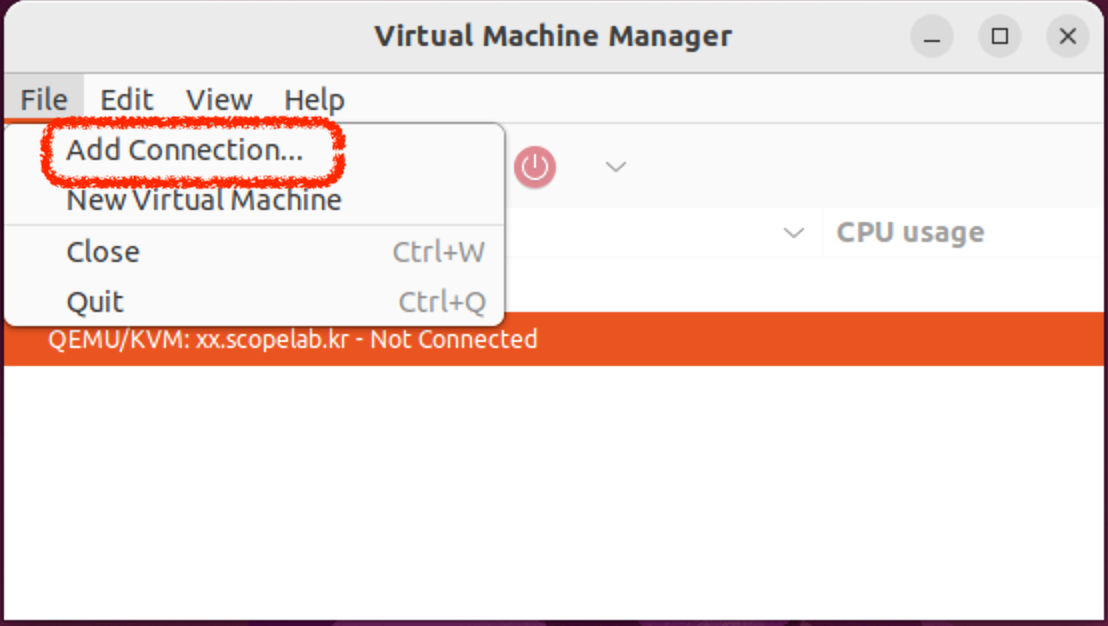

| Virtual Machine Manager로 원격지의 QEMU/KVM에 접속 (KVM Remote Connect) (0) | 2024.03.12 |

| VirtualBox CLI(Command)를 이용하여 VM 관리하기 (0) | 2024.02.16 |